欧美人工智能监管模式及政策启示

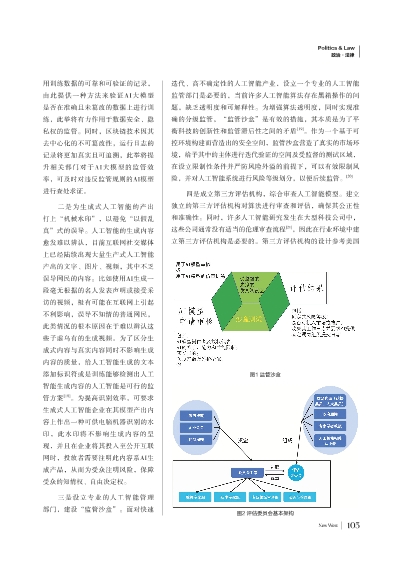

图1监管沙盒

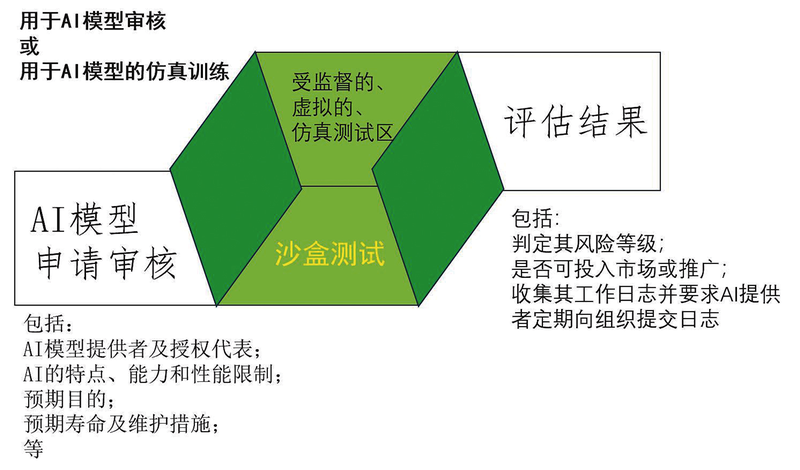

图1监管沙盒  图2评估委员会基本架构

图2评估委员会基本架构 用训练数据的可靠和可验证的记录,由此提供一种方法来验证AI大模型是否在准确且未篡改的数据上进行训练,此举将有力作用于数据安全、隐私权的监管。同时,区块链技术因其去中心化的不可篡改性,运行日志的记录将更加真实且可追溯,此举将提升相关部门对于AI大模型的监管效率,可及时对违反监管规则的AI模型进行查处求证。

二是为生成式人工智能的产出打上“机械水印”,以避免“以假乱真”式的误导。人工智能的生成内容愈发难以辨认,目前互联网社交媒体上已经陆续出现大量生产式人工智能产出的文字、图片、视频,其中不乏误导网民的内容。比如使用AI生成一段毫无根据的名人发表声明或接受采访的视频,极有可能在互联网上引起不利影响,误导不知情的普通网民,此类情况的根本原因在于难以辨认这些子虚乌有的生成视频。为了区分生成式内容与真实内容同时不影响生成内容的质量,给人工智能生成的文本添加标识符或是训练能够检测出人工智能生成内容的人工智能是可行的监管方案[18]。为提高识别效率,可要求生成式人工智能企业在其模型产出内容上作出一种可供电脑机器识别的水印,此水印将不影响生成内容的呈现,并且在企业将其投入至公开互联网时,投放者需要注明此内容系AI生成产品,从而为受众注明风险,保障受众的知情权、自由决定权。

三是设立专业的人工智能管理部门,建设“监管沙盒”。面对快速迭代、高不确定性的人工智能产业,设立一个专业的人工智能监管部门是必要的,当前许多人工智能算法存在黑箱操作的问题,缺乏透明度和可解释性。为增强算法透明度,同时实现准确的分级监管,“监管沙盒”是有效的措施,其本质是为了平衡科技的创新性和监管滞后性之间的矛盾[19]。作为一个基于可控环境构建而营造出的安全空间,监管沙盒营造了真实的市场环境,给予其中的主体进行迭代验证的空间及受监督的测试区域,在设立限制性条件并严防风险外溢的前提下,可以有效限制风险,并对人工智能系统进行风险等级划分,以便后续监管。[20]

四是成立第三方评估机构,综合审查人工智能模型。建立独立的第三方评估机构对算法进行审查和评估,确保其公正性和准确性。同时,许多人工智能研究发生在大型科技公司中,这些公司通常没有适当的伦理审查流程[21],因此在行业环境中建立第三方评估机构是必要的。第三方评估机构的设计参考美国